Sociologue, membre du Conseil consultatif national d’éthique (CCNE), Emmanuel Didier s’intéresse à la « Politique du chiffre », c’est-à-dire à l’usage massif d’indicateurs et d’objectifs quantifiés pour développer des politiques publiques. Contrairement à son sujet un brin austère, c’est un sociologue chaleureux, à l’écoute. Membre du CCNE numérique, il dirige l’Institut santé numérique et société et se concentre sur le rôle de l’éthique dans les évolutions de la santé numérique. Nous avons discuté avec lui autour de l’intelligence artificielle, des droits des malades et des inégalités de santé.

Emmanuel Didier : « J’aime rappeler que je suis statisticien de formation, et si je suis devenu sociologue, c’est pour étudier les statistiques comme un outil de politiques publiques. J’ai ainsi travaillé sur la politique des chiffres. Je me suis penché sur la police, et maintenant sur les transformations sociales apportées par le numérique dans la santé et les soins. Quand je travaillais sur la police, le réflexe était de dire que le problème était avant tout politique, alors que pour la santé, la petite musique est de dire que tout est toujours éthique.

L’IA fait ou fera des erreurs

L’IA peut-elle être un outil de lutte contre les inégalités de santé ? Telle est la question que vous me posez. Aujourd’hui, l’IA connaît donc un succès phénoménal ; elle promet beaucoup et, entre autres, elle promet de rendre le système de soins plus performant. En permettant par exemple de traiter beaucoup plus rapidement les cas simples, ce qui libérerait du temps pour les cas plus difficiles.

Dans cette optique, l’IA ne vise pas à lutter contre les inégalités sociales mais indirectement, elle pourrait faire en sorte que le système de soins soit plus performant. C’est, en tout cas, l’idée qui traîne et qui nous est vendue. Cela se confirmera-t-il ? Ce que l’on voit est que l’on s’en sert à présent beaucoup en radiologie ou en dermatologie pour le traitement d’analyse des images. Dans les autres domaines, constatons que cela reste marginal. Il y a bien des tentatives pour l’utiliser dans le suivi des malades, dans la priorisation des urgences vitales ou dans le retour à domicile, mais cela reste balbutiant.

L’IA, ne l’oublions pas, c’est d’abord et quand même un autre nom pour les statistiques, avec simplement des fortes modifications dans l’usage de l’informatique. Or, les statistiques font des erreurs. Et l’IA fait ou fera des erreurs. Ainsi, sur une image radiologique, elle peut voir ou ne pas voir un nodule. C’est problématique et cela crée en soi des inégalités car cela va dépendre de qui a cet outil entre les mains : un spécialiste pourra se faire une opinion, et corriger ou pas ce que lui propose l’IA. Mais dans les petits hôpitaux, l’isolement peut engendrer plus d’erreurs, et donc accroître des inégalités entre hôpitaux car certains n’auront pas les moyens de disposer de contre-feux.

Un contrôle humain ?

L’IA a besoin de données. Il y a d’abord des données dites « d’apprentissage » pour entraîner l’algorithme. Ensuite, des données de test où il est dit à l’algorithme « voilà des données nouvelles, essayez de les reconnaître ». Et enfin, les données de vie réelles, prises en vrai sur les patients. Or, toutes ces bases de données peuvent entraîner des biais importants, en particulier entre les catégories d’individus. Par exemple en dermatologie, si vous mettez dans votre base de données essentiellement des peaux blanches, il est fort probable que cette IA risque de passer à côté de choses devant des peaux plus sombres. De fait, il y a le risque que les résultats soient ainsi biaisés, et en termes d’inégalités sociales, que l’on les identifie mal.

Comment les éviter ? Dans un rapport, l’Union européenne a développé le concept de contrôle humain, l’idée étant que chaque algorithme dans l’IA doit avoir un contrôle humain. Belle idée, mais qu’est-ce que cela veut dire ? S’agit-il de refaire tous les calculs à la main ? Cela serait impossible ou inutile. Il s’agit, de fait, de faire en sorte que l’industriel vende son algorithme au médecin en soulignant là où se trouvent les points de décisions cruciales. Si cela part d’une bonne intention, cela reste assez vague. Cependant l’IA-Act (règlement européen sur l’intelligence artificielle) insiste sur la responsabilité des acteurs sur ce contrôle humain, avec l’intention affichée que, dans l’hypothèse où l’industriel n’a pas mis en place un contrôle humain et dans le cas où survient un problème, c’est l’industriel qui est responsable.

Des dispositifs très peu évalués

Cela reste, là aussi, très embryonnaire. À présent, l’évaluation des dispositifs médicaux est faite par la Haute Autorité de santé (HAS), et elle n’est faite que si les produits sont remboursés par la Sécu. Or les dispositifs d’IA sont la plupart du temps vendus aux hôpitaux et non pas aux patients, et ces dispositifs ne sont donc pas remboursés, donc très peu de dispositifs d’IA sont évalués par la HAS. Et pour y remédier, la HAS a mis en place un guide à l’achat pour que l’acheteur se pose les bonnes questions.

La certification, c’est-à-dire voir si le ratio bénéfice/risque est positif, ce qui donne le marquage CE qui ouvre les marchés européens, est faite par l’Agence nationale de sécurité du médicament (ANSM), mais il y a beaucoup de failles. L’ANSM n’a pas de définitions des dispositifs médicaux qui soient entièrement numériques. Ensuite, les tests sont pensés par l’industriel lui-même et non pas par l’ANSM, et c’est encore l’industriel qui les faits, les tests étant ensuite analysés par des organismes privés. Au final, cela donne le sentiment qu’il est assez facile de passer à travers ce système de certification. La question demeure : comment faire pour évaluer et certifier les dispositifs d’IA ?

Un instrument de démocratie en santé ?

Dernière question : l’IA peut-elle être un instrument pour aller vers plus de démocratie en santé ? On pourrait, pour cela, imaginer dans un cadre spécifique la mise en place d’un assistant numérique, c’est-à-dire la présence, dans les hôpitaux, d’un acteur, pas nécessairement un médecin, ni un administratif ni même un usager, mais quelqu’un qui aurait une compétence supplémentaire, quelqu’un qui soit capable d’expliquer au patient qu’il va donc être traité en partie avec un dispositif d’IA, dont il évoquerait les risques, les faiblesses, les avantages. Le patient donnerait ensuite son avis, voire son accord.

Au final, il me semble qu’il n’est pas impossible que l’IA, pour certains aspects, rende le système de soins plus efficace, mais le risque sur les inégalités sociales est réel, important même, pas tant à l’intérieur d’un hôpital mais entre hôpitaux, et les inégalités qui existent déjà pourraient dès lors s’en trouver accrues. »

Échanges

VIF : Les statistiques ou les données ne sont-elles pas toujours en retard, décrivant de fait le monde d’hier avec les stéréotypes d’aujourd’hui ? Comment l’IA éviterait-elle ce décalage ?

La démocratie sanitaire s’est construite autour d’un rapport de force, souvent explicite entre usagers, médecins, pouvoirs publics, et firmes pharmaceutiques ? Y en a-t-il un de clair autour de l’IA ?

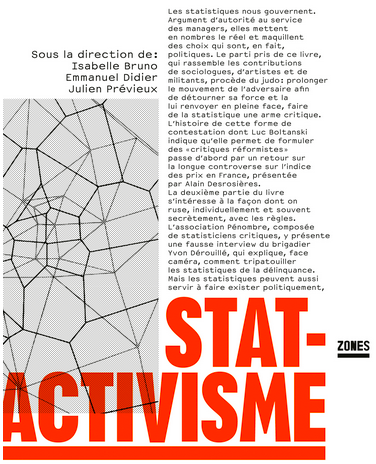

E. D. : Oui, les statistiques peuvent être conformistes, et on ne peut pas être radicalement révolutionnaire en ne s’appuyant que sur elles. Pour autant, il y a des moyens pour s’en servir différemment, et des mouvements qui y réfléchissent, comme le statactivisme où il s’agit de « lutter contre » aussi bien que de « lutter avec » les nombres en utilisant différentes stratégies possibles, comme le « judo statistique », une stratégie de légitime défense dans laquelle les mesures existantes sont « jouées ». Mais aussi de dénoncer l’insuffisance ou le biais ou l’injustice des indicateurs et mesures existants, par exemple à partir des statistiques officielles de la pauvreté ou des inégalités, de développer des indicateurs alternatifs pour remplacer ceux ci-dessus, et d’identifier les contextes et problèmes sociaux invisibles pour les statistiques existantes. On voit des associations qui se saisissent des statistiques pour faire exister et donner de la force à des revendications qui leur sont propres.

Sur le rapport de force, donc oui, il en faut, c’est nécessaire, mais comment l’établir dans le cadre de l’IA ? Je crois aux associations de patients, certaines sont très utiles et très actives, je pense à l’association Renaloo, une association très active sur le numérique, qui se bat pour la greffe en le faisant avec les stats.

Reste l’éthique qui devient omniprésente dans la santé, mais elle est souvent un peu creuse et molle. Pour autant, elle n’est pas inutile, on peut noter que beaucoup de structures et de comités ont publié ces dernières années des rapports, tous assez proches, avec comme un arrière-fond, une petite musique de ce qui n’est pas possible de faire, comme la marchandisation des données de santé. Et ce n’est pas inutile.

Une ou des IA ?

Francis Carrier : Ne fait-on pas erreur en parlant d’une IA alors que j’imagine des IA ; chaque agent en aura une, le directeur d’hôpital aura la sienne, le médecin aussi, et pourquoi l’usager de santé n’aurait-il pas la sienne ? À un moment, il y aura des discussions, voire des conflits entre les IA qui seront aussi des porte-paroles de ceux qui s’en servent. On peut imaginer que le patient sera tout à fait apte à présenter et défendre son IA.

E. D. : Beaucoup d’enquêtes montrent que le patient a un regard positif sur l’IA, mettant en avant le fait que l’IA n’est pas économe de son temps. Vous pouvez lui poser mille fois la question avec des petites variations, et elle vous répondra patiemment. Les patients peuvent se sentir rassurés, voire cajolés par l’IA qui leur montre une patience que les médecins n’ont pas toujours.

Il va falloir se préparer

Bernard Bégaud : L’IA est un continuum, cela fait vingt ans qu’il y a des systèmes qui intègrent et digèrent des données et apprennent. Aujourd’hui en médecine, il y a sur certains diagnostics le constat que l’IA pourra faire mieux qu’un médecin généraliste, et si cela se confirme, c’est en soi une révolution à laquelle nous, médecins, nous devons nous préparer. Interroger ChatGPT avant de voir son médecin peut ainsi devenir une habitude et créer des situations un peu particulières. C’est une évolution possible, à laquelle les facultés de médecine doivent se préparer. Comme la santé est devenu un bien marchand, des gens doivent probablement en plus déjà réfléchir pour faire en sorte que l’IA apporte des réponses qui vont dans le sens souhaité par ces lobbys, par exemple sur la définition des normes cliniques, normes qui étaient avant tout définies par des commissions d’experts. Regardez comment la pensée commune en santé publique peut s’imposer, par exemple sur le cholestérol ou l’usage de statines. On impose des normes cliniques pour tous. Il va falloir se préparer, être prêt, voire combattre.

E. D. : Le problème est que le malade doit se confier à un soignant, or, on ne peut pas se confier à une machine. L’optimum serait que ces systèmes d’IA puissent permettre d’enrichir la vision du médecin et non la remplacer : le médecin ne doit pas être court-circuité dans cette opération.

Je pense surtout à la question de l’accès aux droits. Une grande partie de notre public de l’action sociale ne l’a pas. L’accès aux droits est essentiel dans notre domaine, mais est-ce que l’IA pourra nous y aider ?

Geneviève Crespo

Quid du collectif ?

François Aubart : Je reviens sur l’erreur. C’est un lieu commun de dire qu’en médecine, l’erreur est permanente. Est-ce que l’IA va ajouter de l’erreur à l’erreur, on n’en sait rien. Ce que l’on sait, c’est que dans le dialogue malade-médecin, il y a des outils de garantie de protection de l’erreur qui résident souvent dans la nature collective du travail, avec les structures de services ou universitaires, mais aussi les associations de malades. Le collectif existe et contrôle. Ma question : est-ce qu’il n’y a quelque chose pour contrôler collectivement ? Ne faudrait-il pas qu’il y ait un lieu où l’on travaille ensemble, quelque chose qui donne une plus-value commune, plutôt que laisser faire l’individualisme à quoi renvoie l’IA ?

E. D. : Il y a quelque chose qui me trouble. Le lieu commun est en effet d’affirmer que l’IA ferait moins de fautes que l’être humain, mais qui juge les erreurs ? Qui décide ? Où se fait le jugement ? Si on prend des images et qu’on les soumet à l’IA ou à des humains, ce sont des humains qui comparent l’IA et les humains.

De l’intérêt public ?

François Aubart : Finalement, quelle garantie pour que les logiques économiques ou industrielles ne prennent pas toute la place ? Comment rééquilibrer au regard de l’intérêt public ?

E. D. : Une réponse, je crois, réside dans une formation des médecins, pour qu’ils comprennent bien les avantages et inconvénients. Il est important que les médecins ne soient ni fascinés ni terrorisés par ces méthodes. Il faut apprendre à s’en servir.

Je vous ai parlé des auxiliaires du numérique, mais aussi il faut que les instituts publics nous aident pour rendre responsables les industriels car aujourd’hui, ce n’est pas le cas : on est dans un millefeuille. Les industriels proposent des systèmes d’IA qui sont utilisés par des médecins, mais en cas de problème, la responsabilité ne remonte pas aux industriels, c’est le médecin que l’on accusera.

Et de l’imagination ?

Luc Boltanski : En sciences sociales, ce qui est mon domaine, les inégalités entre chercheurs peuvent d’abord venir de la documentation et effectivement, avec Internet, il y a eu une homogénéisation. Mais la principale inégalité reste l’imagination. Et je n’ai pas compris si l’IA est capable d’imagination. Pour la recherche en sciences sociales, c’est cela qui fait la différence, où et comment trouver tout d’un coup une optique pour regarder le monde, sous un regard nouveau ? Est-ce que l’IA est capable de faire cela ? Freud ou Foucault avaient de l’imagination. Est-ce que l’IA peut faire des pas de côté et accéder à l’imagination ?

E. D. : L’IA trouve des répétitions, fait des listes, et en tant que telle, n’a pas d’imagination. Mais avoir de l’imagination, c’est avoir accès à ces répétitions. L’IA, par ces répétitions qui ne sont pas imaginatives, donne à certains le moyen d’exercer leur imagination.

Des choses positives

Philippe Artières : Ce qui m’a frappé, c’est la vitesse. Cette capacité à produire très vite des données. Mais je me demande si l’on n’a pas déjà vécu cela avec nos smartphones et la révolution numérique. Soudain, on a la bibliothèque du monde entier qui nous est disponible. Si on regarde les choses du bon côté, on peut se dire que c’est une démocratie du savoir, un savoir beaucoup plus accessible. En santé publique, il y a des choses très positives. Que l’on soit à Beyrouth dans un hôpital en ruines ou à Necker, on y a accès.

E. D. : Tout historien des sciences a l’habitude de dire que lorsqu’il y a une avancée en statistiques, cela se traduit aussitôt par une abondance de données, et évidemment trop de données. De ce fait, un des points dans l’analyse de l’arrivée de l’IA, c’est que l’on soit submergé par les données. C’est finalement banal. Reste que dans ce flot de données, il faut trouver des repères, voire établir des prises pour déterminer des orientations possibles de l’IA pour s’y opposer. Il faut penser que l’IA peut se développer dans un sens que l’on ne souhaite pas, et il faut trouver des points pour s’y opposer.

Jean-François Laé : Je pense à l’accès dans les lycées et les collèges où l’IA est de plus en plus utilisée, et je me dis que lever le voile de l’ignorance est toujours positif. Tout dépend, certes, où cela s’inscrit, mais sur le principe que le citoyen accède à un surcroît de connaissances, c’est toujours bon. Parallèlement, il faut lui laisser la capacité d’être critique, mais je crois que le citoyen n’en est pas dupe.

Céline Girard : Je me demande pourquoi cela fait aussi peur, quel endroit cela touche pour que cela produise cet effet-là. Car on pourrait regarder l’IA comme un outil hyper performant, nouveau, dans son cartable. Où cela vient-il toucher l’humain pour provoquer ces craintes ? Est-ce cette massification d’infos qui vient d’un coup, et nous fait peur ?

E. D. : Les industriels n’arrêtent pas de nous promettre des choses extraordinaires, on est confrontés à ce déluge de promesses de bienfaits. On nous sert sur un plateau bien insistant des kyrielles de bienfaits de cette technologie. Il est difficile de ne pas être un peu sceptique ou critique.